Apple vừa công bố một bộ ba nỗ lực mới nhằm mang đến cho trẻ em những cách truy cập an toàn hơn trên iPhone, iPad và Mac.

Các thay đổi quan trọng nhất bao gồm

Tính năng giúp liên lạc an toàn hơn trong ứng dụng tin nhắn

Tính năng phát hiện nội dung lạm dụng và xâm hại trẻ em (CSAM) trên iCloud

Tính năng hiển thị cảnh báo khi người dùng tìm kiếm các nội dung liên quan lạm dụng và xâm hại trẻ em thông qua Siri và công cụ Search

1. Nhắn tin an toàn hơn trên iMessage

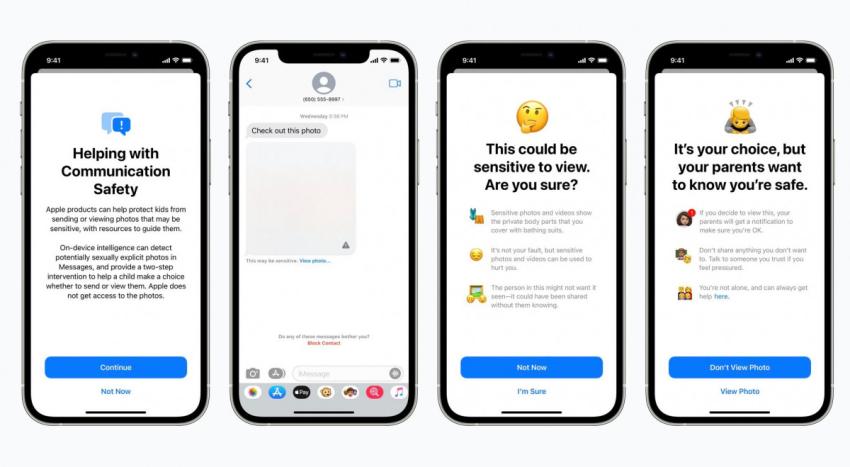

Liên lạc an toàn hơn trong ứng dụng tin nhắn là thay đổi được Apple đề cập đầu tiên trong ngày 5 tháng 8 vừa qua. Theo đó, hãng giải thích rằng nhờ tính năng mới này, khi trẻ em nhận hoặc cố gắng gửi đi những bức ảnh có nội dung nhạy cảm, hệ thống sẽ tự động gửi về một cảnh báo.

Cụ thể hơn, khi trẻ em nhận được một hình ảnh nhạy cảm, hình ảnh đó sẽ bị ứng dụng tin nhắn làm mờ và đính kèm theo một cảnh báo cho biết đó “có thể là hình nhạy cảm”. Nếu trẻ nhấn vào “xem ảnh”, một thông báo khác sẽ tự động bật lên nhằm cung cấp lý do vì sao hình ảnh đó được xếp vào danh mục nội dung không phù hợp với độ tuổi. Không dừng lại ở đó, khi trẻ em bấm vào tùy chọn “tiếp tục xem”, một cảnh báo khác sẽ được gửi đến iCloud Family của phụ huynh để thông báo về hành động đó kèm theo một liên kết nhằm điều hướng người dùng đến trang hỗ trợ.

Trong trường hợp trẻ cố gắng gửi đi một hình ảnh nhạy cảm, chúng cũng sẽ nhận được một cảnh báo tương tự như trên. Apple cho biết cảnh báo sẽ khả dụng trên các thiết bị được sử dụng bởi trẻ dưới 13 tuổi. Đồng thời, nếu chúng vẫn tiếp tục lựa chọn gửi đi hình ảnh sau khi nhận được cảnh báo, một cảnh báo khác nhằm thông báo về hành động này cũng sẽ được gửi đến cho phụ huynh.

Để làm được điều đó, Apple đang tích hợp thêm công nghệ máy học Machine Learning trên các dòng iPhone, iPad và Mac để phân tích các tệp hình ảnh đính kèm nhằm xác định đó có phải là nội dung nhạy cảm hay không. Song, người dùng cũng không cần phải lưu tâm đến vấn đề bảo mật bởi tất cả các tin nhắn trên iMessage đều đã được mã hóa đầu cuối và Apple không có quyền truy cập vào bất kỳ một nội dung nào.

Theo Apple, tính này này sẽ bắt đầu khả dụng vào cuối năm nay trên các tài khoản đã đăng ký iCloud Family đang chạy hệ điều hành iOS 15, iPadOS 15 và macOS Monterey trở lên.

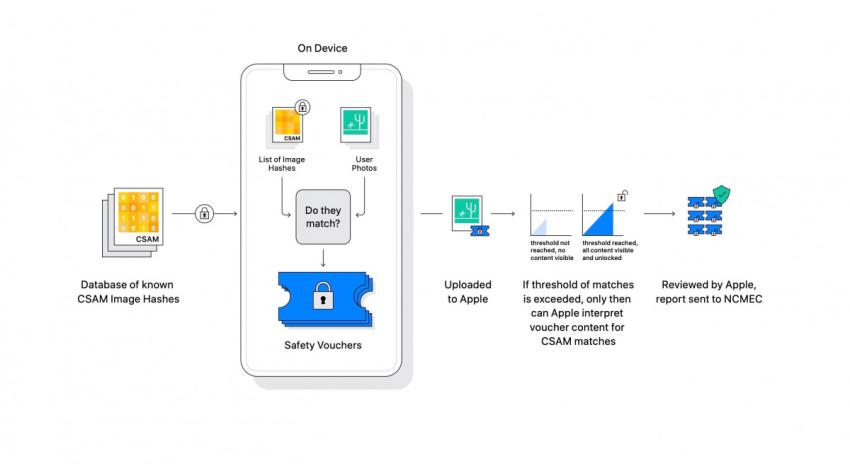

2. Phát hiện CSAM trên iCloud Photos

Thay đổi thứ 2 vừa được giới thiệu là tính năng chặn nội dung lạm dục và xâm hại trẻ em (CSAM).Tính năng này đã bị rò rỉ cách đây một năm và đây là lần đầu tiên Apple xác nhận về sự tồn tại của nó trên iCloud Photos.

Theo đó, Apple cho biết sau khi phát hiện các hình ảnh có nội dung lạm dục và xâm hại trẻ em được lưu trữ trên iCloud Photos, hãng sẽ tiến hành xem xét và gửi báo cáo đến National Center for Missing and Exploited Children (NCMEC) – một cơ quan thực thi pháp luật có nhiệm vụ bảo vệ trẻ em khỏi CSAM.

Ngoài ra, hãng còn liên tục nhấn mạnh rằng phương pháp phát hiện CSAM này được xây dựng chú trọng vào quyền tư của người dùng. Cụ thể, hệ thống do Apple thiết kế sẽ tự động phân tích các hình ảnh trên thiết bị và so sánh với cơ sở dữ liệu hình ảnh do NCMEC cung cấp. Nếu có sự trùng khớp, hình ảnh đó sẽ được một công nghệ có tên Threshold Technolog xem xét để xếp vào danh mục CSAM một cách tự động. Sau đó, Apple sẽ tiếp tục xem xét thủ công một lần nữa trước khi gắn nhãn CSAM, tiến hành vô hiệu hóa tài khoản của người dùng và gửi báo cáo đến NCMEC. Nhờ đó, quá trình này đảm bảo rằng các tài khoản sẽ không bị gắn nhãn sai và gần như không có nhầm lẫn. Apple khẳng định hệ thống quét CSAM này có tỷ lệ lỗi thấp hơn 1 khi xử lý cùng lúc 1 nghìn tài khoản mỗi năm.

Tuy nhiên, trong trường hợp cho rằng mình bị gắn nhãn CSAM sai, người dùng cũng có thể gửi khiếu nại để được khôi phục lại tài khoản.

Apple xác nhận tính năng này sẽ sớm được phát hành rộng rãi vào cuối năm nay và chỉ được sử dụng để phân tích các hình ảnh được lưu trữ trên iCloud Photos. Hình ảnh được lưu trữ cục bộ trên thiết bị sẽ không tham gia vào quá trình này.

3. Cảnh báo khi người dùng tìm kiếm các nội dung CSAM thông qua Siri và Search

Cuối cùng, Apple cũng đang tiến hành nâng cấp Siri và trải nghiệm tìm kiếm thông qua công cụ Search trên iPhone, iPad và Mac.

Dự kiến thay đổi sẽ được cập nhật rộng rãi vào cuối năm nay cho các phiên bản hệ điều hành từ iOS 15, iPadOS 15, watchOS 8 và macOS Monterey trở lên.

“Apple đang mở rộng hướng dẫn cho Siri và công cụ Search trên các dòng thiết bị bằng cách cung cấp các tài nguyên bổ sung nhằm giúp trẻ em và cha mẹ luôn an toàn trên không gian mạng và nhận được sự trợ giúp phù hợp trong các tình huống không an toàn.

Ví dụ: Khi người dùng hỏi Siri cách báo cáo về các hành động lạm dụng hoặc xâm hại trẻ em sẽ, Siri và Search không chỉ trả về thông tin cách báo cáo mà còn cung cấp thêm các thông tin liên quan về cơ quan thực thi pháp luật có thể xử lý báo cáo.

Ngoài ra, Siri và Search cũng đang được cập nhật lại nhằm can thiệp khi người dùng thực hiện tìm kiếm các truy vấn liên quan đến CSAM. Những biện pháp can thiệp sẽ giải thích cho người dùng rằng việc quan tâm đến chủ đề này là bất bình thường và cung cấp thêm các thông tin cụ thể hơn nhằm giải thích cho hành vi này.”

Theo dõi mục Tin Tức của SurfacePro.vn để cập nhật những tin tức mới nhất về công nghệ!

Bài viết liên quan

- Microsoft dừng hỗ trợ Windows 10 21H1, khai tử Windows 7 và Windows 8.1 (16.12.2022)

- Samsung Galaxy S23 có tính năng SOS vệ tinh giống iPhone 14 (28.11.2022)

- Hàng trăm iPhone bị tịch thu do không bán kèm sạc (26.11.2022)

- Apple chi gần 7 tỷ USD để mua lại Manchester United? (25.11.2022)

- iCloud trên Windows dính lỗi bí ẩn, cảnh báo nên cân nhắc khi tải xuống (23.11.2022)